生成式AI催生的变革,除了消费端应用带来交互体验的显著提升外,也在重新定义企业经营。

但目前企业AI的部署仍处于早期,只有10%的企业在其生意模型中部署了生成式AI。虽然有超过50%的企业认为需要部署生成式AI,但都在软硬件等方面遭遇的不同的难题。

过去两年,大模型浪潮推动GPU算力军备竞赛的竞逐,但对于很多企业AI的场景而言,GPU并非唯一的选择,特别是当前大模型的训练逐步进入到推理阶段,考虑到性能、成本、功耗等整体因素,CPU仍然能够发挥价值,而实现AI在企业中的部署,也需要包括GPU、CPU、AI加速器等多样化的解决方案。

英特尔在日前举行的“Intel Vision”大会上,提出企业AI战略,并发布在数据中心处理器、AI加速器,边缘计算、网络等众多创新产品,助力企业AI的加速落地。

企业AI的机遇和挑战

生成式AI正在以越来越快的速度和多样的形式进入企业。当前,人们看到的更多是一些AI提升生产力的应用,比如会议纪要、工作总结,邮件等应用,即辅助功能,并将很快进入智能客服等AI助手时代。而在未来全功能AI时代,不同的助手之间协作互动,基于对多个不同AI数据的交流,为企业提供全方位、精准的信息,届时将会给企业带来巨大价值。

Gartner预计,2026年,80%的企业将会使用生成式AI,50%的企业在边缘计算将会部署各种不同的机器学习或深度学习,从而提升企业竞争力。企业在生成式AI的投资,预计今年会达到400亿美元的规模,到2027年会达到1510亿美元的规模。

在这一过程中,非常关键和具有挑战性的,是企业的数据和知识如何导入现有的AI模型,这涉及到企业隐私数据和通用模型的结合。

传统的方式,无论是公有云还是私有云都有成熟而明确的做法。但目前多为通用AI大模型,算力也都集中在云端等公开场合。当企业将数据在这些模型上进行提炼、升华时,不得不将数据上传到公有云等进行训练,也存在泄露风险。

对于芯片厂商而言,这是一项系统性工程,需要从底层算力、基础设施、软件到应用都要具备相应的策略。也是英特尔提出企业AI的核心要义,通过构建开放、规模性、可靠的生态,帮助企业释放AI潜力。

在算力层面,从云端到边缘再到终端的“混合AI”部署被视为趋势,由于GPU导致的算力军备竞赛和算力焦虑。企业的AI部署需要多种算力,因此,算力需要具备可获取性、隐私性和多样化。

在基础设施层面,既要考虑私有云,也要考虑公有云的部署由,于企业对AI的重要性认知和采用程度的不同,或需要部署规模的时间段不同,单节点、多节点、集群等,因此,需要具备可扩展性和标准化。

在软件层面,需要安全可靠。理想状态下,相应的软件可以有一个公开的API或者开源。同时,企业可以通过社区获取更多能力。ISV软件供应商可以以开源软件为基础,开发出更通用的多样的软件模块。

在应用层面,基于上述软件模块,可以使用这些能力,并针对企业的难题提供更便捷、更开放的应用软件。

上述四个层面,构成了英特尔企业AI的关键组成部分。

据英特尔公司市场营销集团副总裁、中国区数据中心销售总经理、中国区运营商销售总经理庄秉翰介绍,首先从算力入手,英特尔在数据中心、在边缘和终端,都提供多元算力,而且这些算力不仅能够带来性能上的提升,还具备隐私性。

在基础设施的形态上,通过与OEM携手,当企业自行部署时,可以和OEM采买服务器或服务器集群,或者将一部分对隐私要求较低的数据上传如公有云、互联网等做相关的AI训练与集群。

在软件生态方面,英特尔提供OneAPI、OpenVINO或PyTorch。其中PyTorch已经成为主流AI设计框架。基于此,软件供应商ISV也会做出各种不同的软件模块,更便于在上层应用的融合。

此外,英特尔也会提供域控等新技术,通过整合企业内部多种敏感数据与通用的大型人工智能模型,显著提升企业数据的利用效率并发挥其潜在优势。这一过程涉及到多种软件模块的应用,而这些模块的开放性和可靠性至关重要。通过使这些软件模块更加开放和可靠,ISV能够利用这些模块构建多样化的最终应用程序。

“对于企业而言,这也意味着它们不再受限于单一的垂直解决方案供应商,而是可以根据自己的经验、偏好和需求,自由选择合作的硬件和软件供应商。此外,企业也拥有自主研发或外部采购软件的灵活性,从而实现更灵活的技术整合和业务创新。这样不仅能够加速企业对AI的应用,也可以真正把AI的能力释放出来。整体来看,不管是AI助手,还是AI助手的互融性,最终是把企业自己的知识和数据,可以转到生成式AI的使用上。”庄秉翰说。

大模型不只属于GPU

生成式AI所推动的智能涌现正在催生数据中心市场新的变化。

在庄秉翰看来,去年新的数据中心建设,资源会优先侧重在智算中心,而到了今年,通用数据中心恢复到之前的节奏进行持续建设,同时智算数据中心建设也在加速。

原因在绝大多数企业目前的利润结构大多仍基于通用数据中心的应用。尤其是当前CPU迭代非常迅速,每一代CPU又会带来新的性能提升和能耗减少。所以在保持现有业务增长上,企业依然非常需要通用数据中心。因此从去年下半年开始,通用数据中心建设又恢复到原来的节奏。

传统的通用数据中心本就是英特尔的基本盘,而在智算数据中心,对英特尔而言也是巨大的机遇。

一方面,这些智算数据中心中建设,会使用英特尔的AI加速产品。另一方面,大部分基于GPU的服务器仍然需要CPU,带来数据中心处理器需求量的增加。比如大模型RAG(检索增强生成)技术中,除了运算引擎之外,数据库、查找等等其他的功能也都需要CPU来完成。所以GPU服务器上往往也配备了英特尔的CPU产品。

此外,就智算中心而言,关于生成式AI大模型,去年行业普遍关注是模型训练,“百模大战”之下,性能成为追求的重要指标,GPU用量激增,而对成本和功耗并无太多重视。

而随着随着很多通用大模型被训练出来,行业关注的重点则转到了推理一端,功耗就变得非常重要,因为推理是大规模部署,所以需要对智算中心的成本、功耗以及整体运营运维进行考量。如果采用逐步部署生成式AI的节奏,就可以通过CPU先来做一些大模型的应用部署。当不需要生成式大模型时,还可以转换到通用的应用,这也是一种可以实现盈利的方式。

“在推理方面,不光是GPU,除了GPU还有CPU也能用于推理。而且从很多案例里可以看到,130亿参数以下的大模型中,CPU是可以做到的这一点的。对企业来说,大模型也处在初始阶段,不需要立即部署一个很大的GPU集群,这对于运维和开发来说都是很大的挑战。我们也看到一些客户愿意尝试用CPU做大模型推理。还有很多互联网公司,之前更多提供的是基于GPU的大模型服务,现在也提供基于CPU的大模型,尤其是在推理上。”庄秉翰表示。

实际上,不仅是英特尔,AMD也有类似的观点。在AMD去年举办的“Advancing AI”活动上,AMD就进行了在EPYC 9654处理器上运行Llama 2大语言模型的展示。当时,AMD方面表示,在某些场景下,依靠CPU提供的AI算力也能够进行大模型处理,而非仅依靠GPU,这对于具有较少GPU资源的企业而言非常具有吸引力,也带来了成本上的节省。

因此,企业AI实现有效的部署,关键在于因地制宜,要挑选最适合企业的人工智能策略,基于该策略挑选最适合的基础设施和架构。场景不同,对于CPU、GPU、边缘、云端的算力需求策略各不相同,当大模型和生成式AI的热潮退去,企业在面对变现、产生价值时将变得更加实际,思考落地的经济适用性和最合适合的方案。而对于英特尔等芯片厂商而言,则是要具备多样化算力支持能力,以及易部署、可扩展、低成本的解决方案。

至强6焕新助力企业AI落地

作为英特尔数据中心服务器品牌,至强系列自推出以来一直扮演着数据中心领域的底层基石角色,也持续引领数据中心市场的创新风潮。进入大模型时代后,至强系列也日益成为英特尔企业AI战略中的重要组成部分。

过去几年,算力军备竞赛,成本高企,企业所需要的,是如何能够在算力可及的前提下保证性能,并实现易部署。在英特尔梁雅丽看来,“开放”和“易部署”,是未来企业AI策略能够落地的一个重要关键点。英特尔始终坚持强调与生态系统伙伴的合作,这也是英特尔长期以来的核心竞争力之一。

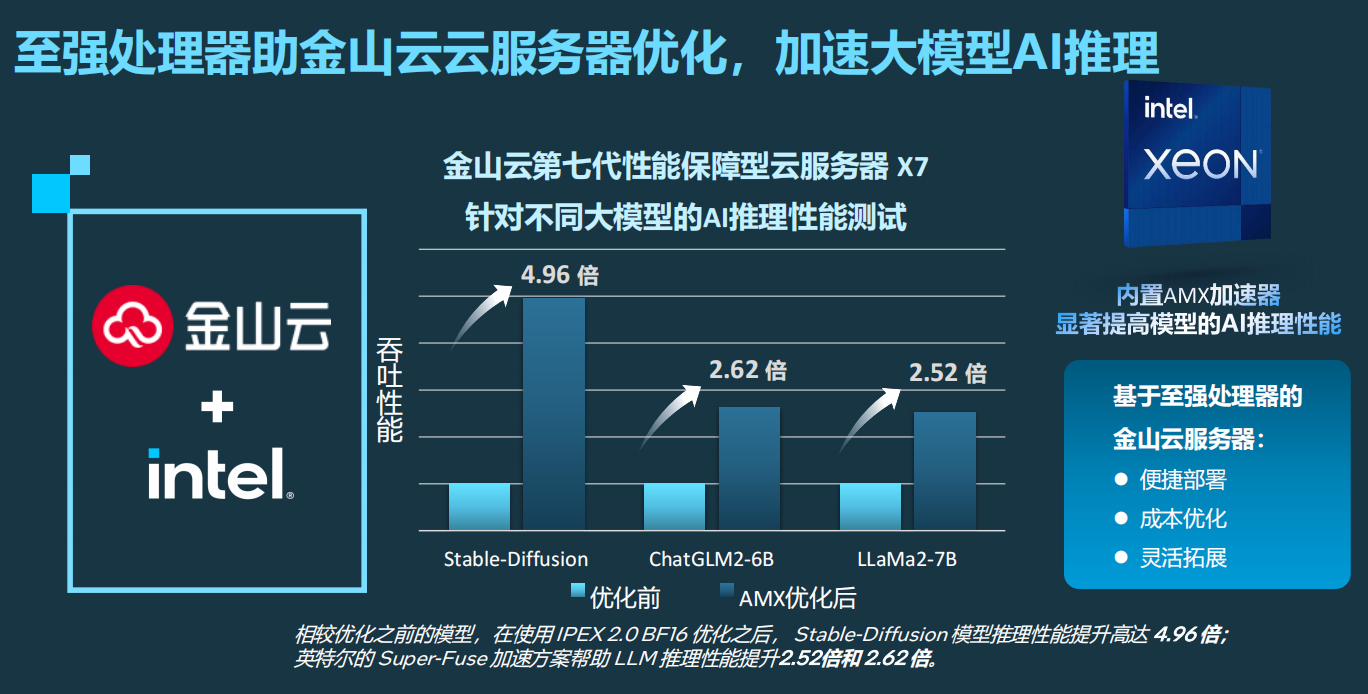

以英特尔和金山云的合作为例,在其第七代性能保障型云服务器 X7 中引入了第四代至强可扩展处理器进行了针对性优化。同时,在 Stable Diffusion、Llama2、ChatGLM2 三款十分流行的大模型基础上做了调优,并发布优化的模型镜像。

相较优化之前的模型,英特尔至强内置AMX加速器优化后的文生图大模型 Stable Diffusion,其推理性能提升高达4.96倍。在常用的开源大语言模型 Llama2 和 ChatGLM2 模型上,优化后的模型推理性能也分别取得了2.62倍和2.52倍的显著提升。

英特尔公司市场营销集团副总裁、中国区云与行业解决方案部总经理梁雅莉表示,企业部署AI首先考虑的是“可及”,即该算力是能够购买、获取和通用的;二是追求不错的性能,三是在易部署的情况下,能够拥有可靠的保障。

“如今,X7云服务器也拥有了广泛的客户。这些客户是被什么所吸引呢?我认为很简单,第一是便捷的部署,即用户无需部署专用的AI推理服务器,而是可以在通用云服务器的基础上,通过调优的大模型镜像,快速、灵活地实现高效的模型推理;第二是成本优化;第三,是除了大模型推理之外,用户还可以调度金山云云服务器灵活运行其它负载,实现敏捷切换。”梁雅丽表示。

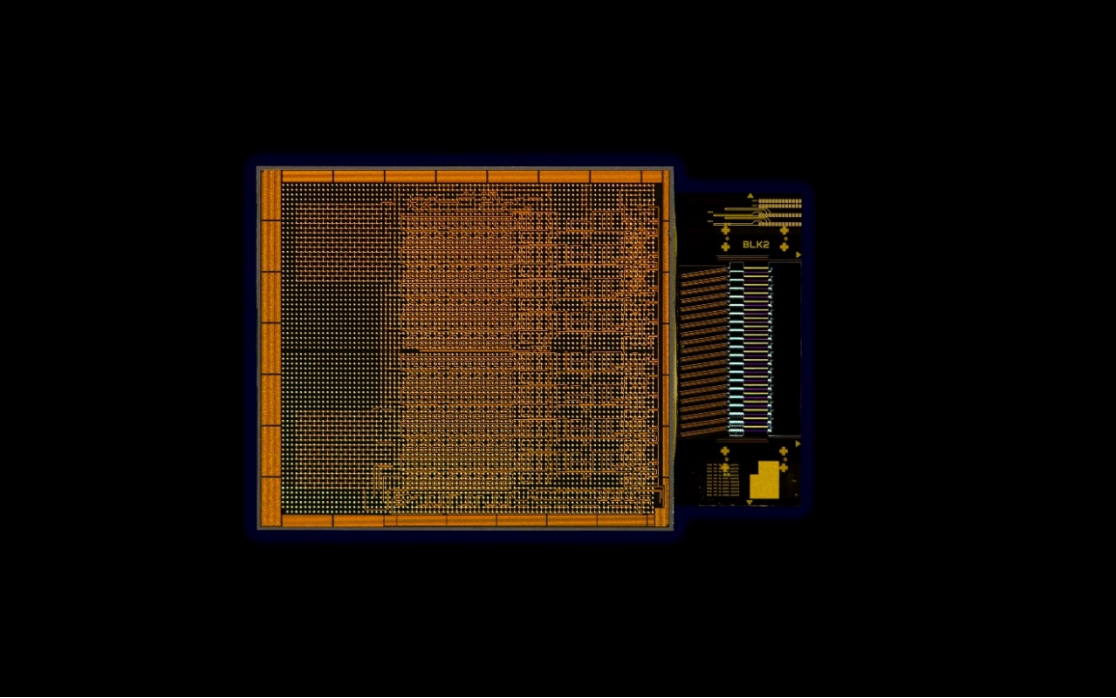

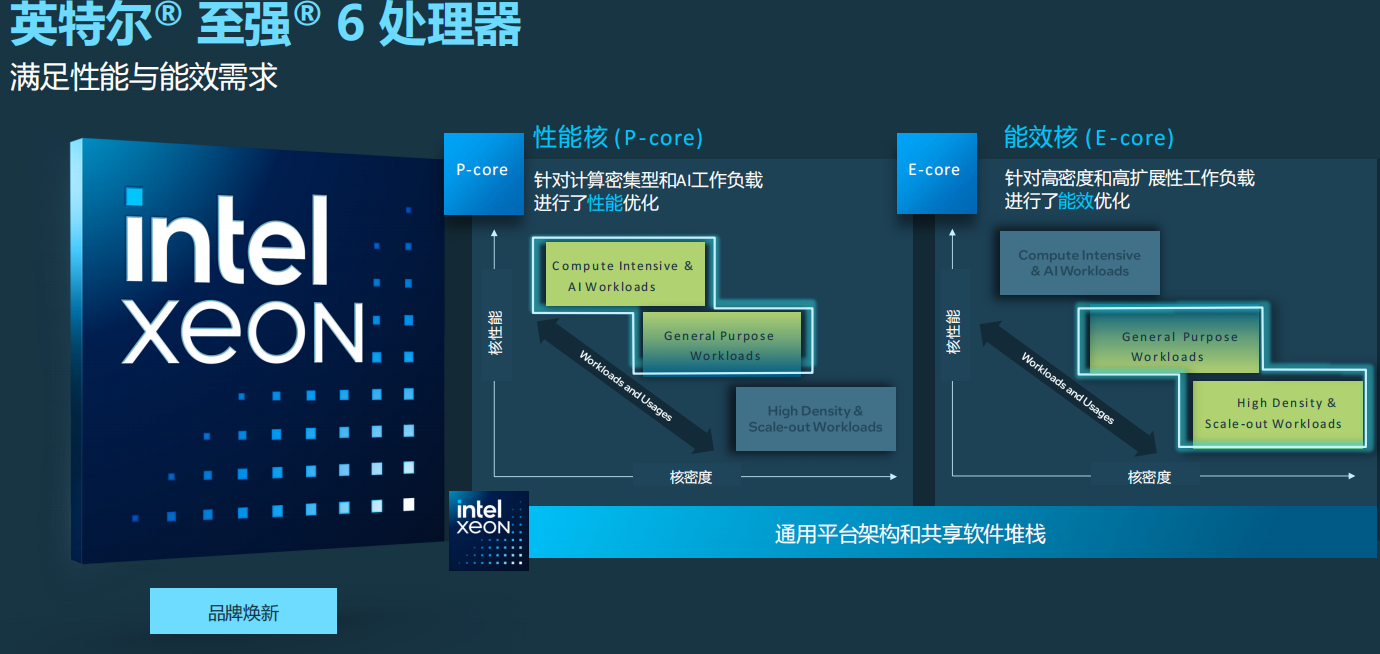

此次“Intel Vision”大会上,英特尔宣布至强6的品牌焕新。与以往每一代至强的发布基本上都是某一款产品不同,全新的至强6以产品组合形式出现。通过性能核(P-core)和能效核(E-Core)两个不同的微架构,从而可以解决数据中心在性能、功耗,以及多元工作负载等方面的各种不同问题。

配备能效核的处理器相较于传统的至强可扩展处理器,在能效方面实现了显著提升。与第二代英特尔至强处理器相比,每瓦性能提高2.4倍,机架密度提高2.7倍。不仅大幅减少了所需的物理空间,还能够节省超过1兆瓦的功耗。在当前国内对节能减排和能耗要求日益严格的背景下,配备能效核的英特尔至强6处理器无疑是一个理想的选择,它不仅提高了能源利用效率,还有助于实现节能减排的目标。

配备性能核的英特尔至强6处理器也有很大的性能提升。它不仅能够支持MXFP4数据格式,在传统的FP16有性能提升,也可以运行700亿参数的Llama2。所以不管是配备性能核还是能效核的至强6处理器,都有整体性能以及每瓦性能的较大提升。

“AI和大模型已经热议了两年,这些技术的未来到底在哪里?实际上就蕴藏于行业之中。最重要的并非是拥有大模型,而是AI技术该如何落地,并且为客户带来真正的价值,这是英特尔一直致力于探索的方向。”梁雅莉说。