沉浸式全息影像、虚拟数字人员工、数字藏品、虚拟营业厅、城市数字孪生、超写实数字人......近日举办的2022世界人工智能大会成了众多元宇宙应用的博物馆。在亦真亦幻的展示中,元宇宙的精彩已经扑面而来。

不过,元宇宙的完全落地还需满足多重条件,其中之一就是要得到端侧和边缘侧AI的强力支撑。因为,AI部署在端侧可以提升用户数据的安全性,并助力高效地利用有限的网络资源和带宽;而在边缘侧,AI则能及时处理多种元宇宙场景下的海量数据,并推动AI整体的规模化部署和提升云端智能水平。

其实,支撑元宇宙只是端侧和边缘侧AI的应用目标之一。随着AI技术不断融入边缘侧和端侧,各节点都将获得空前强大的计算和决策能力。在此过程中,作为AI技术的具体载体,边缘侧和端侧AI芯片将发挥无可比拟的作用。

边缘侧和端侧AI的崛起

边缘侧是一个经常被提起又难以被理解的概念,在物联网的世界特指为设备端的附近,而为应用开发者和服务提供商在网络的边缘侧提供云服务和IT环境服务就称为边缘计算。当边缘计算、AI和应用场景相结合,就产生了边缘侧AI。由于边缘侧覆盖了各种应用场合和设备,边缘侧AI得到了无比广阔的发展空间。

边缘侧AI运行在边缘设备上,相较于云端的AI,其数据安全性更高,功耗更低,时延更短,可靠性更高,带宽需求更低,还可以更大限度的利用数据,以及进一步缩减数据处理成本。

相对来说,端侧AI更容易理解,活跃在我们的手机和其他各种终端设备上的AI技术就是端侧AI。与边缘侧AI相同,端侧AI运行在本地设备上,使得其更加安全、高效,也不会对带宽有过分依赖。

由于传感器技术的进步和5G的普及,边缘侧AI开始大规模部署,并为制造、医疗健康、金融服务、交通、能源等行业开发出新的业务模式,如制造行业的预测维护和医疗行业的AI诊疗等。同时,端侧 AI 在底层技术和业务应用等方面也取得了快速发展,逐渐从尝试性应用变成驱动业务创新的核心推动力之一,计算摄影、智能门禁、车载ADAS等应用就是最好的证明。

这些端侧和边缘侧AI的主流应用中都采用了智能视觉技术,结合图像识别与AI训练,构建起强大的智能视觉应用生态。

因为感知场景非常碎片化,面对越发复杂的场景应用,智能视觉所面临的技术挑战也日益艰巨。比如,在暗光、逆光场景下输出高质量图像就是行业公认的难题。解决的办法之一就是采取多光谱融合技术,将可见光与红外光感知信息进行融合,在不增加光污染的同时,解决低照环境下由于可见光感光能力不足所造成的细节损失的问题,实现图像色彩与细节的最佳平衡。爱芯元智采用AI ISP的方式,对传统ISP的某些能力进行增强,能够实现黑光全彩的效果。

同样,为了做到对不同目标的区分和运动场景下的目标识别,结构化识别、多算法融合也是必要的技术。诸如此类的AI算法越来越多,就意味着需要强大的AI算力作为支撑,也意味着作为端侧和边缘侧AI最直接载体的AI芯片必须要在算力和感知方面不断创新,才能发挥出算法的最大作用。

算力和感知:NPU和ISP的完美融合

在端侧和边缘侧AI芯片中,负责提供算力的主要是NPU单元。它是整个AI芯片中非常重要的一个模块,能够很好地支持最新的深度学习算法,且算力表现远超传统的CPU/GPU。

不过NPU也面临着内存墙和功耗墙的挑战,要发挥NPU的潜力,降低开发成本,需要特殊的技术——混合精度。

混合精度就是将不同精度的浮点数/定点进行数值计算。业内专家通过研究发现,通过合理分配不同环节的数值精度,就可在保证最终计算结果准确度的条件下,实现整体计算的加速。

爱芯元智设计了混合精度的NPU,可以在端侧边缘侧成本受限的情况下提供充沛的有效算力,支持更多的智能算法。

该NPU是一个异构多核的系统,除了专注于网络本身加速的CONV计算核外,还配有丰富的在Vector内核上实现的CV算子,同时还会有SDMA等用于数据的搬运,使得算力在AI图像处理中能够有更好的提升。

为了降低NPU系统对 CPU的占用,爱芯元智还专门设计了多核硬件同步的机制,这样整个应用的绝大部分Pipeline都可以跑在NPU上,不对CPU占用,从而让整个应用跑得更快。

NPU的强大算力在智能视觉应用中有了巨大的发挥空间。因为智能视觉的感知是由AI ISP所负责,为了能应对更加复杂的场景应用,需要将服务器上的AI分析处理能力前移放入ISP中,没有强大算力的支撑,这就是一个无法完成的任务。

比如,在智慧城市场景中,使用AI ISP可以解决暗光背景下的噪声问题,输出清晰的画面,但使用AI ISP的技术,就必须用AI算法全分辨率、全帧率地对视频进行处理。仅一个500万像素的视频码流,要做到全分辨率、全帧率的处理,就会对NPU的算力提出非常高的要求。

另一方面,要对场景进行智能分析,就要把一些行业专家系统用神经网络的方式进行构建。这个AI专家系统要足够聪明,对应的就是一个庞大的神经网络,要让其顺利运转,也会对NPU算力提出很高的要求。

当然,仅有强大的算力也是不够的,要让AI ISP发挥最大的潜力,还需要对算法进行选择,如果将所有算法进行装载,势必会加重芯片的运算负担和功耗,反而会影响芯片的表现。

爱芯元智公司进行了很好的创新,其没有将AI ISP整体的Pipeline进行替换,只择其中重要的模块进行AI增强,将有限的算力集中于整个AI ISP中最关键、人眼最可知的这些功能中,以实现整个AI ISP的最佳效果。这样不但能使得画质明显改善,还能随AI模型迭代实现快速升级。

为了让NPU和ISP实现强强联合,爱芯元智还开发了联合架构设计,最终大幅提升了传统ISP中多个关键模块的性能,将AI画质提升算法应用到4K视频显示上。

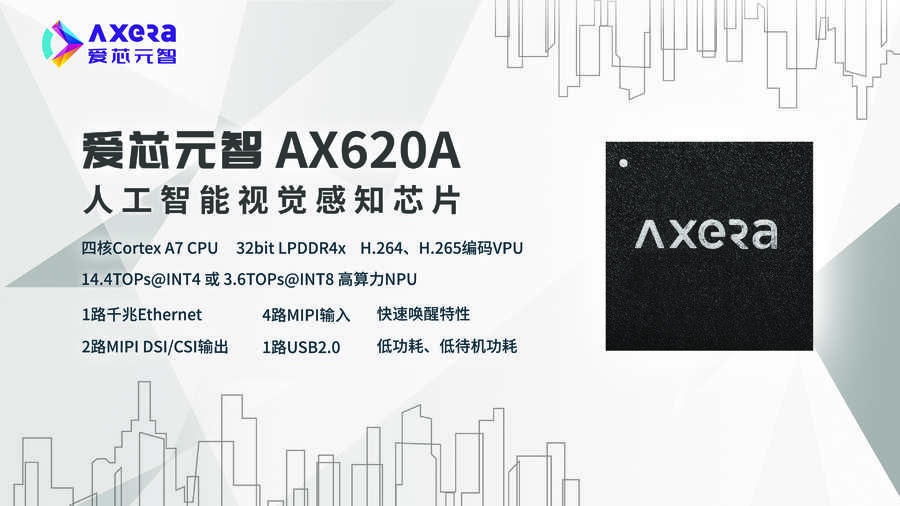

爱芯元智的两个主要产品完美体现了上述设计思路。其中,AX620A是目前在智慧城市等应用中的主流产品,拥有一个四核Cortex-A7CPU,32bitLPDDR4x,包含H.264、H.265编码功能,算力为14.4TOps,有两路的MIPI,一路的USB,具有快速唤醒、低功耗的特点。

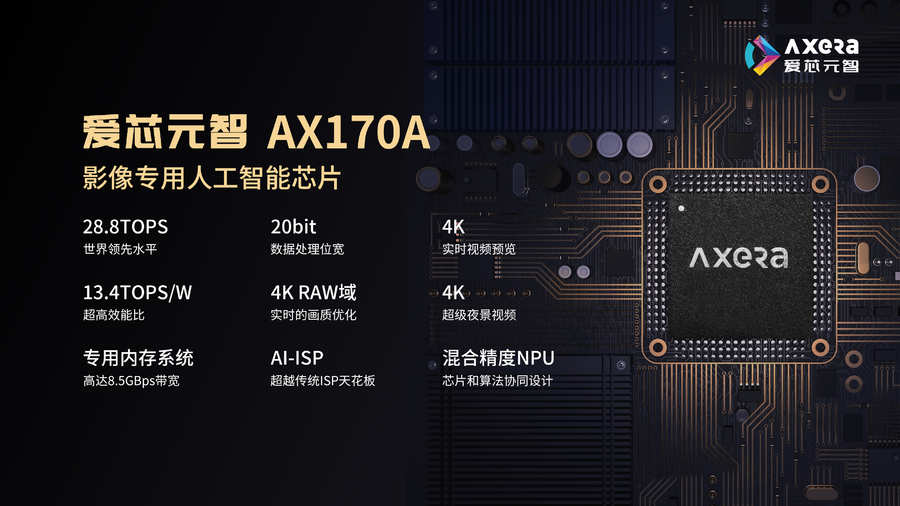

另一款产品是AX170A,为影像方面专用的人工智能芯片,集成了四核Cortex A7 CPU、自研AI-ISP和混合精度NPU,同时片上搭载LPDDR4专用内存,可以支持4路MIPI信号输入;最高算力可达28.8TOPS,独立DDR带宽最高可达到8.5GBps,可对4K 30fps的影像进行实时画质优化,配合主控芯片可实现超级夜景视频和优秀的暗光拍摄功能。

写在最后

端侧和边缘侧AI正在随日益增长的实时性业务需求而变得愈发重要,IDC 预测,到 2023 年,接近20%的用于人工智能工作负载的服务器将部署在边缘。

可以预期,AI芯片将有更广阔的市场空间,同时也要增加与算法和应用场景的契合度。对于厂商来说,可以针对不同应用自主开发算法,只是这样将耗费大量的资源,也不可能实现全覆盖。是否还可存在别的路径呢?

在这方面,爱芯元智的做法可以值得借鉴。其提供了对多种框架生成的AI算法的支持,也可以广泛接收来自于不同厂商的算法,通过离线编译优化的工具进行编译,或利用其提供的分析工具对性能做一些分析,从而实现算法在芯片上的部署和快速迭代。

在自主开发的基础上,增加兼容性,这也许就是今后端侧和边缘侧AI芯片发展的新方向。(校对/萨米)